FADA

PEFT(2/4)

Motivation

现有的 DGSS 方法分为三类:第一类把样式信息和表达信息解耦,但是并没有确保得到一个强大的特征表征能力。第二类直接关注内容的表征能力,没有考虑跨域风格变换的能力。第三类方法侧重于在训练过程中尽可能丰富风格。前两类因为现在大家都在用 mask2former 做 decoder,所以这样体现出来的效果更好。

想法就是把 LoRA 引入频率空间,高频成分代表的是风格,低频成分代表的是语义内容。接下来通过小波变换把 VFM 特征转换到频率空间里,在低频的空间里用可学习标记

Methods

回顾一下 rein 里的范式,我们把 peft 的过程凝练为以下范式:

$$

f_{i+1} = W_if_i + M_i(T_i(W_if_i))

$$

我们要 lora 的目标就是 $T_i \in R^{m\times c}$,也就是令 $T_i = A_i\times B_i$

根据之前的内容,我们可以利用 Haar 小波变换把频率空间分离成低频和高频分量。作者分离成四部分分量:$LL^T,LH^T,HL^T,HH^T$,其中直接使用了二维的核:

$$

L^T = \frac{1}{\sqrt{2}}[1,1],H^T = \frac{1}{\sqrt{2}}[-1,1]

$$

其实 $L,H$ 的本质一个是取平均值,一个是做差。通过把两个矩阵相乘得到的 kernel,$LL^T$ 实际上就是求像素响应的平均值,也就是考虑了低频细节,而剩下三个分别从行,列,对角线三个角度考虑了高频细节。然后把每层的 $f_i$ 分别做一个乘法得到 $f_i^{LL}$

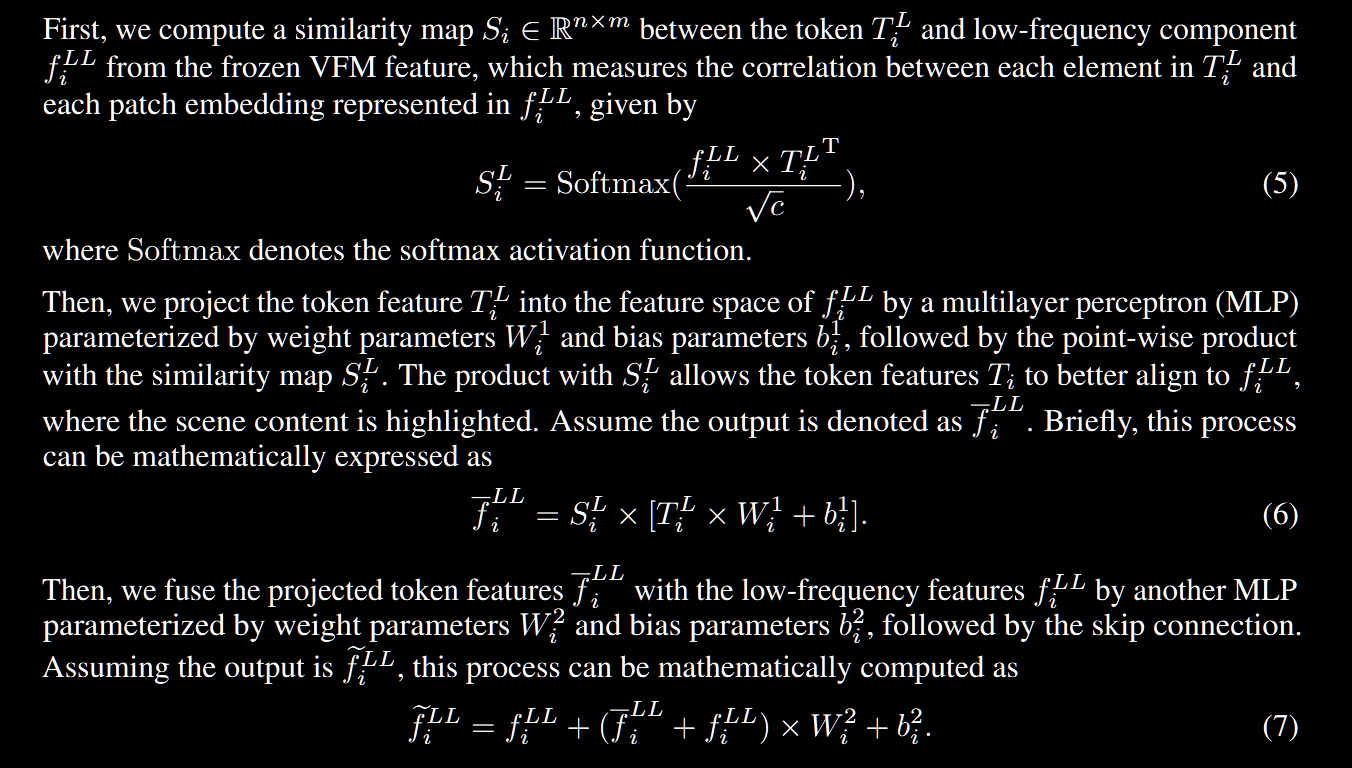

第二步是做一个低频自适应,这部分内容和 rein 基本一致,但是我们只对 $f^{LL}$ 进行学习,同样建立相似度矩阵,同样做一个类似 attention 的东西,之后对特征进行残差链接。

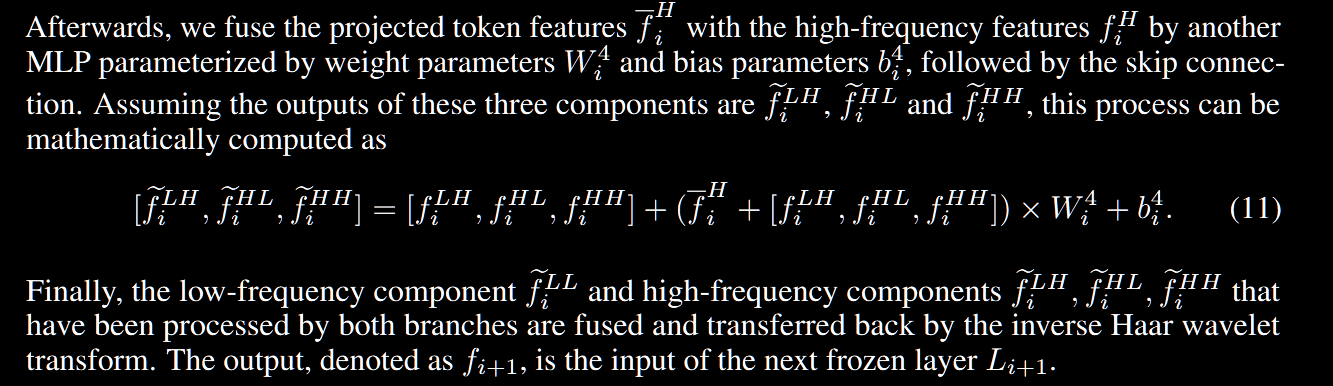

对于高频特征的处理,实际上是把 $f^{LH},f^{HL},f^{HH}$ concat到一起之后和上面做差不多的过程,但是我们在得到 softmax 后的 $S_i^H$ 之后会把她做实例归一化,也就是抹平这些响应的剧烈变化。它强制性地将这些强烈的、可能带有源域偏见的“风格信号”进行白化处理,从而削弱了源域风格对特征微调过程的主导作用。也就是不会让 $f$ 太过被影响了

最后得到这些新的 $f$ 之后做一个逆小波变换回去。所以上面的东西本质上就是拆成高低频之后做 cross-attention。但是因为分开高低频空间所以更有道理了!